Tα deepfakes δημιουργούνται με την Τεχνητή Νοημοσύνη, τροφοδοτούνται από τον μισογυνισμό και είναι ο νέος σκοτεινός τρόπος κακοποίησης των γυναικών.

Deepfake πορνό: Όταν οι γυναίκες κακοποιούνται με ένα ψέμα που γίνεται πραγματικότητα

Tα deepfakes δημιουργούνται με την Τεχνητή Νοημοσύνη, τροφοδοτούνται από τον μισογυνισμό και είναι ο νέος σκοτεινός τρόπος κακοποίησης των γυναικών.

Tα deepfakes δημιουργούνται με την Τεχνητή Νοημοσύνη, τροφοδοτούνται από τον μισογυνισμό και είναι ο νέος σκοτεινός τρόπος κακοποίησης των γυναικών.

Tα deepfakes δημιουργούνται με την Τεχνητή Νοημοσύνη, τροφοδοτούνται από τον μισογυνισμό και είναι ο νέος σκοτεινός τρόπος κακοποίησης των γυναικών.

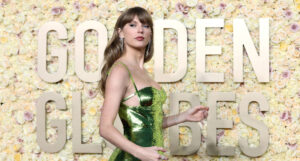

Η εξάπλωση των deepfake πορνογραφικών φωτογραφιών της Taylor Swift στην πλατφόρμα X, ήταν ταχύτατη. Τα αντανακλαστικά του πρώην Twitter καθυστέρησαν τόσο πολύ, που μία φωτογραφία συγκέντρωσε 47 εκατομμύρια προβολές πριν κατέβει.

Χρειάστηκε, μάλιστα, να κινητοποιηθούν οι θαυμαστές της διάσημης ποπ τραγουδίστριας με μαζικές αναφορές για να κατέβουν οι φωτογραφίες και το X να μπλοκάρει τις αναζητήσεις της. Όμως το αίσθημα οργής που ξέσπασε ήταν τόσο μεγάλο, που έκανε μέχρι και τον Λευκό Οίκο να δηλώσει έντονη ανησυχία για το ζήτημα.

Για τις γυναίκες που έχουν πέσει θύματα δημιουργίας και διαμοιρασμού μη συναινετικού πορνογραφικού υλικού deepfake, τα γεγονότα γύρω από την Taylor Swift ήταν μία φρικτή υπενθύμιση της δικής τους κακοποίησης.

Παρόλο που υπάρχει η ελπίδα πως η περίπτωση της Swift θα αναγκάσει τους νομοθέτες να αναλάβουν δράση, εντούτοις τα θύματα δεν είχαν την ευκαιρία να δουν τις δικές τους φωτογραφίες να κατεβαίνουν.

Αντιθέτως, η περίπτωση της ποπ τραγουδίστριας απέχει πολύ από τον κανόνα. Τα περισσότερα θύματα, ακόμα και αυτά που είναι διάσημα, συνεχίζουν να βρίσκουν deepfake φωτογραφίες τους.

Δεν έχει σημασία ποια είσαι, πόσο ισχυρή είσαι

Η 17χρονη ηθοποιός της Marvel, Xochitl Gomez, μίλησε για την αποτυχία του X να αφαιρέσει τα πορνογραφικά deepfakes της. Μιλώντας για τις ψεύτικες φωτογραφίες της, η Gomez ανέφερε χαρακτηριστικά πως «αυτό δεν έχει καμία σχέση με εμένα. Κι όμως βρίσκεται εδώ με το πρόσωπό μου».

Η Noelle Martin είναι άλλη μία γυναίκα που επέζησε από την αυτήν την κακοποίηση, καθώς έπεσε θύμα δημιουργίας και διαμοιρασμού μη συναινετικών σεξουαλικών deepfake φωτογραφιών της.

Ανακάλυψε για πρώτη φορά ότι το πρόσωπό της χρησιμοποιήθηκε σε πορνογραφικό περιεχόμενο πριν από 11 χρόνια. «Οι καθημερινές γυναίκες σαν και εμένα δεν θα έχουν εκατομμύρια ανθρώπους να δουλεύουν για να μας προστατεύσουν και να βοηθήσουν στην κατάργηση του περιεχομένου, ούτε θα έχουμε το προνόμιο οι μεγάλες εταιρείες τεχνολογίας, οι οποίες διευκολύνουν την κακοποίηση, να ανταποκριθούν».

Η Martin, η οποία είναι ακτιβίστρια και ερευνήτρια στο εργαστήριο Tech & Policy Lab στο πανεπιστήμιο της Δυτικής Αυστραλίας, αναφέρει πως αρχικά βρισκόταν αντιμέτωπη με παραποιημένες φωτογραφίες, αλλά τα τελευταία χρόνια που η Τεχνητή Νοημοσύνη έχει γνωρίσει άνθιση, δημιουργούνται και βίντεο, τα οποία μοιράζονται σε πορνογραφικές ιστοσελίδες.

«Είναι αρρωστημένο, είναι σοκαριστικό» δηλώνει χαρακτηριστικά, προσθέτοντας πως «προσπαθώ να μην τα βλέπω. Αν τα συναντήσω, είναι απλά…Δεν ξέρω καν πώς να το περιγράψω, είναι ένα ποτάμι πόνου, πραγματικά».

«Ακόμα και αν οι φωτογραφίες δεν είναι ιδιαίτερα ρεαλιστικές και πάλι είναι αρκετές για να προκαλέσουν ανεπανόρθωτη βλάβη σε ένα άτομο», συνέχισε η Martin.

Όσον αφορά στη διαδικασία για να αφαιρεθούν αυτές οι φωτογραφίες από το διαδίκτυο, καλή τύχη.

«Η αφαίρεσή τους είναι μία μάταιη διαδικασία. Είναι μία δύσκολη μάχη και ποτέ δεν μπορείς να εγγυηθείς την πλήρη απομάκρυνσή τους από τη στιγμή που βρίσκονται εκεί έξω». Όπως λέει και η ίδια, επηρεάζει τα πάντα «από την εργασία σας μέχρι και τις μελλοντικές σας ικανότητες να κερδίσετε πράγματα από τις σχέσεις σας. Είναι μία αναπόφευκτη μορφή κακοποίησης, οι συνέπειες της οποίας λειτουργούν στο διηνεκές».

Η Martin έχει αναγκαστεί να το αναφέρει σε συνεντεύξεις για δουλειά. «Είναι κάτι για το οποίο πρέπει να μιλήσεις στα πρώτα ραντεβού. Παραβιάζει κάθε πτυχή της ζωής σου», σημειώνει.

Η Laura Bates είναι ακτιβίστρια και συγγραφέας του βιβλίου Men Who Hate Women, το οποίο αποτελεί έρευνα για τα πιο σκοτεινά σημεία του διαδικτυακού μισογυνισμού.

Όταν δημοσίευσε το βιβλίο, οι άνδρες τής έστελναν φωτογραφίες όπου η Bates παρουσιαζόταν να εκτελεί «όλα τα είδη σεξουαλικών πράξεων, συμπεριλαμβανομένων ατόμων που μου έστελναν επεξεργασμένες φωτογραφίες μου, ώστε να φαίνεται πως τους έκανα στοματικό σεξ».

Η ίδια αναφέρει πως είναι δύσκολο για τους ανθρώπους να καταλάβουν τις επιπτώσεις, ακόμα και όταν ξέρουν ότι οι φωτογραφίες δεν είναι αληθινές.

«Υπάρχει ένα πολύ βαθύ συναίσθημα που είναι αδύνατο να αγνοήσεις, όταν βλέπεις μία απίστευτα υπερρεαλιστική φωτογραφία σε φαντασίωση κάποιου για εσένα, γεμάτη μισογυνισμό», λέει η ίδια, προσθέτοντας πως «υπάρχει κάτι πραγματικά εξευτελιστικό και ταπεινωτικό σε αυτό. Σου μένει στο μυαλό. Και αυτή η εικόνα μπορεί να μοιραστεί ενδεχομένως με εκατομμύρια ανθρώπους».

Όπως λέει η Bates, τα deepfake πορνογραφικά υλικά «κυκλοφορούν σε ακραίες κοινότητες μισογυνισμού». Ωστόσο, στην περίπτωση των deepfakes της Taylor Swift ήταν αξιοσημείωτο «πόσο πολύ επιτρεπόταν να κυκλοφορούν και στα κυρίαρχα social media. Ακόμα και όταν στη συνέχεια ανέλαβαν δράση για να τις κατεβάσουν, μέχρι τότε οι φωτογραφίες είχαν εξαπλωθεί σε χιλιάδες άλλα φόρουμ και ιστοσελίδες».

Deepfake σημαίνει πορνογραφία

Μία μελέτη του 2019 από την εταιρεία κυβερνοασφάλειας Deeptrace, διαπίστωσε ότι το 96% του διαδικτυακού περιεχομένου deepfake, ήταν μη συναινετικό πορνογραφικό υλικό. Όταν λοιπόν η χρήση της Τεχνητής Νοημοσύνης είναι κατά συντριπτικό βαθμό για τη δημιουργία deepfake πορνογραφίας, τότε δεν έχουμε να κάνουμε με ένα μικρό πρόβλημα.

Η Bates σημειώνει χαρακτηριστικά πως είναι «απλώς ο νέος τρόπος ελέγχου των γυναικών. Παίρνεις κάποια σαν την Swift, η οποία είναι εξαιρετικά επιτυχημένη και ισχυρή και τη βάζεις πίσω στο κουτί της. Είναι ένας τρόπος να πεις σε κάθε γυναίκα: δεν έχει σημασία ποια είσαι, πόσο ισχυρή είσαι, μπορούμε να σε υποβιβάσουμε σε σεξουαλικό αντικείμενο και δεν μπορείς να κάνεις τίποτα γι’ αυτό».

Από αυτήν την άποψη, δεν είναι κάτι καινούργιο, λέει η Bates, «αλλά είναι η διευκολυνόμενη εξάπλωση αυτής της συγκεκριμένης μορφής παθολογικού μισογυνισμού και θα πρέπει να μας ανησυχεί πόσο ομαλοποιημένη και αποδεκτή είναι».

Και ανήλικα θύματα

Η Rani Govender είναι υπεύθυνη πολιτικής και δημοσίων σχέσεων στην NSPCC. Όπως αναφέρει η ίδια, γνωρίζουμε «ότι αυτό είναι ένα θέμα που επηρεάζει απόλυτα τους νέους. Όπως και σε άλλες μορφές σεξουαλικής κακοποίησης, επηρεάζει ιδιαίτερα τα κορίτσια».

Έχουν υπάρξει περιπτώσεις παιδιών που δημιουργούν φωτογραφίες deepfake άλλων παιδιών χρησιμοποιώντας διάφορες εφαρμογές. Στη συνέχεια, αυτές διαμοιράζονται στα σχολεία και χρησιμοποιούνται ως μορφή σεξουαλικής παρενόχλησης και εκφοβισμού.

«Ο φόβος είναι ένα θέμα που εμφανίζεται συχνά. Είναι η ανησυχία ότι οι άνθρωποι θα νομίζουν ότι είναι αληθινό, ότι μπορεί να οδηγήσει σε περαιτέρω σεξουαλική παρενόχληση και εκφοβισμό. Υπάρχει ανησυχία για το τι μπορεί να σκεφτούν οι γονείς τους», λέει η Rani.

Ένα 14χρονο κορίτσι δήλωσε πέρυσι στην υπηρεσία τηλεφωνικής γραμμής της NSPCC ότι μια ομάδα αγοριών έφτιαξε ψεύτικες φωτογραφίες σεξουαλικού περιεχομένου για εκείνη και άλλα κορίτσια και τις έστειλε σε ομαδικές συνομιλίες. Τα αγόρια αποβλήθηκαν από το σχολείο για ένα διάστημα, αλλά αργότερα επέστρεψαν.

Στα κορίτσια είπαν πως θα πρέπει να προχωρήσουν, μία απαίτηση που δεν είναι καθόλου εύκολη. Ένα άλλο κορίτσι, 15 ετών, δήλωσε ότι ένας άγνωστος πήρε φωτογραφίες από τον λογαριασμό της στο Instagram και έφτιαξε ψεύτικες γυμνές της, χρησιμοποιώντας την πραγματική της κρεβατοκάμαρα ως φόντο.

Αυτού του είδους το υλικό δημιουργείται από αγνώστους στο διαδίκτυο ως μέρος μίας διαδικασίας, η οποία μπορεί να χρησιμοποιηθεί για να εκβιάσει και να απειλήσει τα παιδιά. Η Τεχνητή Νοημοσύνη επομένως χρησιμοποιείται και για τη δημιουργία φωτογραφιών σεξουαλικής κακοποίησης παιδιών, οι οποίες διαμοιράζονται και πωλούνται από τους δράστες. Ακόμα και τα παιδιά που δεν έχουν στοχοποιηθεί, εξακολουθούν να είναι ευάλωτα στο να δουν την εξάπλωση της deepfake πορνογραφίας.

Όπως ανέφερει η Govender, «υπάρχει ήδη μία μεγάλη πρόκληση με την ποσότητα πορνογραφικού υλικού που είναι εύκολα διαθέσιμη στα παιδιά στα social media», προσθέτοντας πως «αν η παραγωγή και ο διαμοιρασμός τέτοιου υλικού γίνεται όλο και πιο εύκολη υπόθεση, τότε αυτό θα έχει πραγματικά αρνητικές επιπτώσεις και στην αντίληψη των παιδιών για τη σοβαρότητα αυτών των εικόνων».

Υπάρχουν βέβαια και περιπτώσεις στοχοποίησης ανδρών ιδίως σε χώρες όπου η ομοφυλοφιλία είναι απαγορευμένη, αλλά στη συντριπτική τους πλειοψηφία τα θύματα είναι γυναίκες.

Οι νόμοι δεν αρκούν

Σύμφωνα με τη νέα πράξη διαδικτυακής ασφάλειας του Ηνωμένου Βασιλείου, η ανταλλαγή μη συναινετικού πορνογραφικού υλικού deepfake είναι παράνομη.

«Δεν νομίζω ότι κανείς περιμένει μεγάλο αριθμό ποινικών καταδικών, αλλά τεχνικά πολλές από τις κοινοποιήσεις αυτών των εικόνων της Taylor Swift θα συνιστούσαν ποινικό αδίκημα», λέει η Clare McGlynn, καθηγήτρια νομικής στο Πανεπιστήμιο του Ντάραμ και ειδική σε θέματα κακοποίησης βάσει των φωτογραφιών.

Όπως λέει η McGlynn, για χρόνια η θέση της βρετανικής κυβέρνησης ήταν πως οι ψεύτικες φωτογραφίες δεν είναι σημαντικές.

«Αν και φυσικά το ισχυρίζονταν αυτό χωρίς να μιλούν με τα θύματα. Πρόκειται για ένα ευρύτερο ζήτημα της διαδικτυακής κακοποίησης κατά των γυναικών και των κοριτσιών που δεν λαμβάνεται τόσο σοβαρά υπόψη. Οι άνθρωποι δεν κατανοούν ότι οι βλάβες από αυτό μπορεί να είναι βαθιές, καταστροφικές και συνεχείς. Δεν συμβαίνει μία φορά και μετά μπορείτε να προσπαθήσετε να το ξεπεράσετε και να συνεχίσετε τη ζωή σας. Είναι πάντα πιθανό να υπάρχει στο διαδίκτυο και να επανεμφανίζεται».

Για την McGlynn ο νόμος για την ασφάλεια στο διαδίκτυο είναι μία χαμένη ευκαιρία. «Το αδίκημα αφορά μόνο τη διανομή μιας αλλοιωμένης εικόνας. Δεν αφορά τη δημιουργία της. Και αφήνει τις πλατφόρμες να ξεφύγουν πολύ εύκολα».

Όσο η Tεχνητή Nοημοσύνη βελτιώνεται, θα γίνονται όλο και πιο εύκολα διαθέσιμα τα εργαλεία της.

Ψεύτικες ειδήσεις, εκστρατείες παραπληροφόρησης και deepfake πορνογραφία είναι ήδη εδώ. Η κατάσταση μπορεί να γίνει ακόμα χειρότερη, σε βαθμό που δεν έχουμε φανταστεί, καθώς εργαλεία της Τεχνητής Νοημοσύνης μπορούν πλέον να αναπαράγουν ακόμα και τη φωνή κάποιου ατόμου.

«Πρέπει να ξεπεράσουμε την ιδέα ότι επειδή είναι διαδικτυακό ή επειδή χαρακτηρίζεται ως ψεύτικο, δεν είναι επιβλαβές» λέει η Bates. «Οι άνθρωποι πιστεύουν ότι αυτό δεν είναι βία. Δεν υπάρχει καμία λογοδοσία για τις εταιρείες τεχνολογίας που επιτρέπουν σε αυτά τα πράγματα να διαδίδονται. Δεν υπάρχει καμία τιμωρία για το γεγονός ότι επιτρέπουν να συμβεί κάτι τέτοιο».

Όπως αναφέρει η Bates, «είτε πρόκειται για ένα κορίτσι στο σχολείο, είτε για μία γυναίκα της οποίας η φωτογραφία έχει αντιγραφεί, είτε για μία παγκόσμια ποπ σταρ, από τη στιγμή που αυτές οι εικόνες κυκλοφορούν, είναι ήδη πολύ αργά».

Με πληροφορίες από Guardian