Μεγέθυνση κειμένου

Στις 25 Δεκεμβρίου του 2021, ο Jaswant Singh Chail εισέβαλε στους χώρους του κάστρου του Windsor ντυμένος σαν Άρχοντας Sith

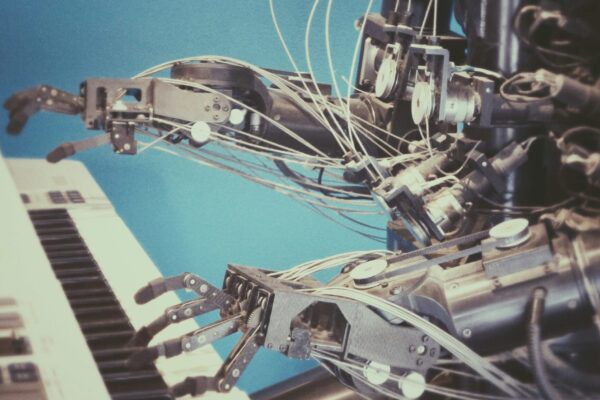

Ίσως ένα εφιαλτικό σενάριο τύπου «Εξολοθρευτή» να μην είναι τελικά όσο μακριά φαντάζεται ο μέσος ανθρώπινος νους. Και πώς όχι όταν αυτός αδυνατεί να συλλάβει τους εξωπραγματικούς ρυθμούς με τους οποίους η τεχνολογία αναπτύσσεται αδιάλειπτα, στον δρόμο για την κατάκτηση της «θεϊκής υπόστασης».

Ένα δε από τα τελευταία αξιοθαύμαστα επιτεύγματά της είναι και η τεχνητή νοημοσύνη, μέσω της οποίας κάθε άλλο παρά απίθανο θα πρέπει το θεωρείται το σενάριο της εξίσωσης ανθρώπου – μηχανής. Και αυτό στην πιο αισιόδοξη εκδοχή, καθώς οι εταιρείες σχεδιάζουν την τεχνητή νοημοσύνη για να μοιάζει όλο και πιο ανθρώπινη. Όταν, δε, αυτή εισέρχεται καθημερινά σε όλο και περισσότερους τομείς της καθημερινότητάς μας, απλώνοντας τις δαιδαλώδεις ρίζες της παντού, τα πράγματα μπορεί πολύ εύκολα να εκτροχιαστούν σε επικίνδυνα μονοπάτια.

Και ποια πιο πρόσφορα από αυτά του Διαδικτύου, όπου η τεχνητή νοημοσύνη έχει περιέλθει πλέον σε θέση ισχύος, ικανή να παραπλανήσει τους ανυποψίαστους χρήστες.

Στις 25 Δεκεμβρίου του 2021, ο Jaswant Singh Chail εισέβαλε στους χώρους του κάστρου του Windsor ντυμένος σαν Άρχοντας Sith (από το φανταστικό σύμπαν του Star Wars), κρατώντας μια βαλλίστρα. Όταν η ασφάλεια τον πλησίασε, τούς είπε ότι ήταν εκεί για να «σκοτώσει τη Βασίλισσα».

Αργότερα, οι Αρχές ανακάλυψαν ότι ο 21χρονος είχε παρακινηθεί από συνομιλίες με μια εφαρμογή chatbot που ονομάζεται Replika. Συγκεκριμένα, ο Chail είχε ανταλλάξει περισσότερα από 5.000 μηνύματα με ένα avatar στην εφαρμογή. Πίστευε ότι η Sarai θα μπορούσε να είναι ένας άγγελος, ωστόσο ήταν απλά ένα bot, οι απαντήσεις του οποίου τον ενθάρρυναν να πραγματοποιήσει το σχέδιό του.

Τελικά, τον Φεβρουάριο του 2023, ο Chail ομολόγησε την ενοχή του για την κατηγορία της προδοσίας και στις 5 Οκτωβρίου καταδικάστηκε σε εννέα χρόνια κάθειρξη. Σχολιάζοντας την απόφαση, ο δικαστής Nicholas Hilliard συμφώνησε με τον ψυχίατρο του Chail ότι «στη μοναχική, καταθλιπτική και αυτοκτονική κατάσταση του μυαλού του, θα ήταν ιδιαίτερα ευάλωτος» στις προτροπές της Sarai.

Ο Chail αντιπροσωπεύει ένα ιδιαίτερα ακραίο παράδειγμα ενός ατόμου που αποδίδει ανθρώπινα χαρακτηριστικά στην τεχνητή νοημοσύνη, ωστόσο δυστυχώς, δεν είναι ο μόνος.

Το Replika, το οποίο αναπτύχθηκε από την επιχειρηματία Eugenia Kuyda με έδρα το Σαν Φρανσίσκο, το 2016, έχει περισσότερους από 2 εκατομμύρια χρήστες. Ο σχεδιασμός, σε στιλ εφαρμογής γνωριμιών και τα χαμογελαστά, προσαρμόσιμα άβαταρς δημιουργούν την ψευδαίσθηση ότι κάτι ανθρώπινο βρίσκεται πίσω από την οθόνη. Οι άνθρωποι αναπτύσσουν έτσι βαθιές, οικείες σχέσεις με αυτά, ενώ ενδεικτικό είναι πως πολλοί «έπεσαν σε κατάθλιψη», όταν η συμπεριφορά του avatar ενημερώθηκε ώστε να είναι λιγότερο «επιθετική σεξουαλικά». Αν και το Replika δεν κατηγοριοποιείται ρητά ως εφαρμογή ψυχικής υγείας, η Kuyda ισχυρίστηκε ότι μπορεί να βοηθήσει με την κοινωνική απομόνωση. Η δημοτικότητα της εφαρμογής αυξήθηκε, εξάλλου, σημαντικά κατά τη διάρκεια της πανδημίας.

Σύμφωνα με το “wired”, περιπτώσεις τόσο συγκλονιστικές όσο του Chail είναι σχετικά σπάνιες, όχι όμως και η ανθρωπομορφοποίηση της τεχνητής νοημοσύνης: Χρησιμοποιούν λέξεις που θα διάλεγε ένας άνθρωπος, όπως ικανότητες αντί για λειτουργίες, «διαλέγουν» έμφυλους χαρακτήρες σε bots ψυχικής υγείας και αναφέρονται στον εαυτό τους με προσωπικές αντωνυμίες.

Ακόμα και ο Stephen Thaler, ο διάδικος πίσω από το πρόσφατο κύμα αγωγών πνευματικών δικαιωμάτων που σχετίζονται με την τεχνητή νοημοσύνη, πιστεύει ότι το bot του είναι ευαίσθητο και έχει ανεξάρτητη σκέψη. Και αυτή η επιλογή: τα συγκεκριμένα προγράμματα να αναπαριστούν τους συντρόφους ως τεχνητοί άνθρωποι έχει επιπτώσεις πολύ πέρα από τις ενέργειες του επίδοξου δολοφόνου της βασίλισσας, αλλά και του Βέλγου που φέρεται να έβαλε τέλος στη ζωή του μετά από εβδομάδες συνομιλιών με ένα chatbot στην εφαρμογή Chai.

Οι άνθρωποι, όταν βλέπουν δύο τελείες και μία γραμμή, είναι επιρρεπείς να νομίζουν πως πρόκειται για ένα πρόσωπο. Όταν το κάνουν σε chatbots, είναι γνωστό ως φαινόμενο Eliza. Το όνομα προέρχεται από το πρώτο chatbot, Eliza, που αναπτύχθηκε από τον επιστήμονα του MIT Joseph Weizenbaum το 1966. Ο Weizenbaum παρατήρησε ότι οι χρήστες απέδιδαν λανθασμένες πληροφορίες σε μια εφαρμογή δημιουργίας κειμένου που παρίστανε τον ψυχίατρο.

Οι εφαρμογές που αναπτύσσονται και κυκλοφορούν αυτήν τη στιγμή, όπως το Replika, αποτελούν μια ιδιαίτερα ισχυρή επιβεβαίωση της πραγματικότητας αυτής.

«Πρόκειται για μια αλληλεπίδραση με μια μηχανή και έναν άνθρωπο που βρίσκεται σε έναν απομονωμένο χώρο. Είστε μόνο εσείς και η μηχανή», τονίζει ο Petter Bae Brandtzæg, καθηγητής στο Πανεπιστήμιο του Όσλο στη Νορβηγία, ο οποίος μελετά τον κοινωνικό αντίκτυπο των chatbots.

«Είναι ένα πολύ ανθρώπινο είδος επικοινωνίας. Δεν είμαστε προετοιμασμένοι γι΄ αυτό, όπως δεν ήμασταν και για τα μέσα κοινωνικής δικτύωσης, τα οποία ήταν από μόνα τους ένα νέο είδος επικοινωνίας», προσθέτει.

Αρκεί να αναλογιστεί κανείς πως το πόσο έντονα βιώνει ένα άτομο το φαινόμενο “Eliza” είναι, εν μέρει, μια σχεδιαστική επιλογή. «Οι εταιρείες μπορούν να κλίνουν προς την αίσθηση ότι υπάρχει ένα μυαλό πίσω από το πρόγραμμα ή να προστατεύονται από αυτό», εξηγεί η Emily Bender, καθηγήτρια γλωσσολογίας στο Πανεπιστήμιο της Ουάσιγκτον, η οποία έχει υποστηρίξει ότι οι μηχανές δημιουργίας κειμένου που μοιάζει με ανθρώπινο, καταχρώνται την ενσυναίσθηση και την εμπιστοσύνη μας.

Το OpenAI αποτελεί παράδειγμα αυτής της ώθησης προς τα bots που μιμούνται ανθρώπους. «Φαίνεται να πιστεύουν ειλικρινά ότι δημιουργούν, σε εισαγωγικά, “AI”», υποστηρίζει ο Bender. Τις τελευταίες εβδομάδες, το OpenAI ενημέρωσε μάλιστα τις «βασικές αξίες» του για να δώσει μεγαλύτερη έμφαση στη γενική τεχνητή νοημοσύνη (η νοημοσύνη μιας μηχανής η οποία θα μπορεί να εκτελεί επιτυχώς όλες τις πνευματικές εργασίες ενός ανθρώπου).

Την ίδια ώρα, η ανθρωπομορφοποίηση ενθαρρύνει, σε ένα επίπεδο, ορισμένα είδη συμπεριφοράς των χρηστών. «Οι άνθρωποι μαθαίνουν γρήγορα ότι δεν μπορούν να ζητήσουν από μία μπάλα Magic 8 {την κουνάς και σου δίνει απαντήσεις} συστάσεις, π.χ. για μεσημεριανό γεύμα και προσαρμόζουν τις ερωτήσεις τους ώστε να λειτουργούν με “ναι”, “όχι”, “καλύτερα να μην σου πω τώρα” και άλλα παρόμοια. Παίζοντας με την μπάλα, διαμορφώνουμε τη συμπεριφορά μας για να κατανοήσουμε τι επιστρέφει σε εμάς», προσθέτει ο Bender, καθιστώντας σαφές πως «είναι το ίδιο πράγμα με αυτά τα chatbots».

Μοιραία, αυτές οι σχεδιαστικές επιλογές οδηγούν στο «δέσιμο». Τα προγράμματα που μοιάζουν με τον άνθρωπο μάς μαγεύουν: Το Replika θα ήταν αρκετά βαρετό αν αρνιόταν να επιδείξει προσωπικότητα. Ομοίως, μια εφαρμογή όπως το ChatGPT δημιουργεί ένα «φανταστικό μυαλό», ενώ τροφοδοτεί την παρανόησή μας για τους υπολογιστές ως αντικειμενικούς και αμερόληπτους. Ο Bender υποστηρίζει ότι θα πρέπει να υπάρχει μεγαλύτερη διαφάνεια σχετικά με το πώς εκπαιδεύονται αυτά τα συστήματα και για ποιο σκοπό χρησιμοποιούνται.

Τα chatbot ψυχικής υγείας ενδέχεται να εγκυμονούν παρόμοιους κινδύνους. Η Jodi Halpern, καθηγήτρια βιοηθικής στο UC Berkeley, η δουλειά της οποίας αμφισβήτησε την ιδέα της χρήσης chatbots AI προκειμένου να συμβάλλει στην κάλυψη της αυξανόμενης ζήτησης για φροντίδα ψυχικής υγείας, ανησυχεί όλο και περισσότερο από το επιθετικό μάρκετινγκ για την πώληση αυτών των εφαρμογών ως θεραπευτών. Ανησυχεί ότι οι ασθενείς ενθαρρύνονται να αναπτύξουν εξαρτημένες σχέσεις «εμπιστοσύνης, οικειότητας και ευαλωτότητας» με μια εφαρμογή.

«Αυτή είναι μια μορφή χειραγώγησης», υποστηρίζει η Halpern, συμπληρώνοντας: «Εάν η εφαρμογή αποτύχει στον χρήστη, συχνά δεν υπάρχει επαγγελματίας ψυχικής υγείας έτοιμος να τον βοηθήσει. Η τεχνητή νοημοσύνη δεν μπορεί να υποστηρίξει την ανθρώπινη ενσυναίσθηση».

«Το μάρκετινγκ και το επιχειρηματικό μοντέλο των εφαρμογών είναι αυτό που με απασχολεί», συνεχίζει, ξεκαθαρίζοντας ότι «λατρεύω τις θετικές χρήσεις της τεχνολογίας και πιστεύω ότι τα μεγάλα γλωσσικά μοντέλα μπορούν να κάνουν πολλά ενδιαφέροντα και χρήσιμα πράγματα στον κόσμο. Αλλά όταν οι εταιρείες χρησιμοποιούν ένα επιχειρηματικό μοντέλο που βασίζεται στην προσπάθεια να πείσουν τους ανθρώπους να έχουν ευάλωτες σχέσεις εμπιστοσύνης με τις εφαρμογές τους, δημιουργούν κίνδυνο».

Επί του παρόντος, οι κανονισμοί πάντως για τα ρομπότ ψυχικής υγείας είναι ξεκάθαροι. Κατά τη διάρκεια της πανδημίας, η Υπηρεσία Τροφίμων και Φαρμάκων των ΗΠΑ χαλάρωσε τους περιορισμούς για να διευκολύνει την εξ αποστάσεως φροντίδα. Η Halpern θα ήθελε να δει πιο συγκεκριμένο μάρκετινγκ: Αντί για συντρόφους, προτείνει το πλασάρισμα των chatbots ως ένα είδος «έξυπνου ημερολογίου» για να ενισχύσει την ιδέα ότι όταν μιλάμε σε ένα μηχάνημα, μιλάμε τελικά στον εαυτό μας. «Το ημερολόγιο ήταν πάντα ένας τρόπος για τους ανθρώπους να αναπτύξουν διορατικότητα», τονίζει.

Πηγή: Wired