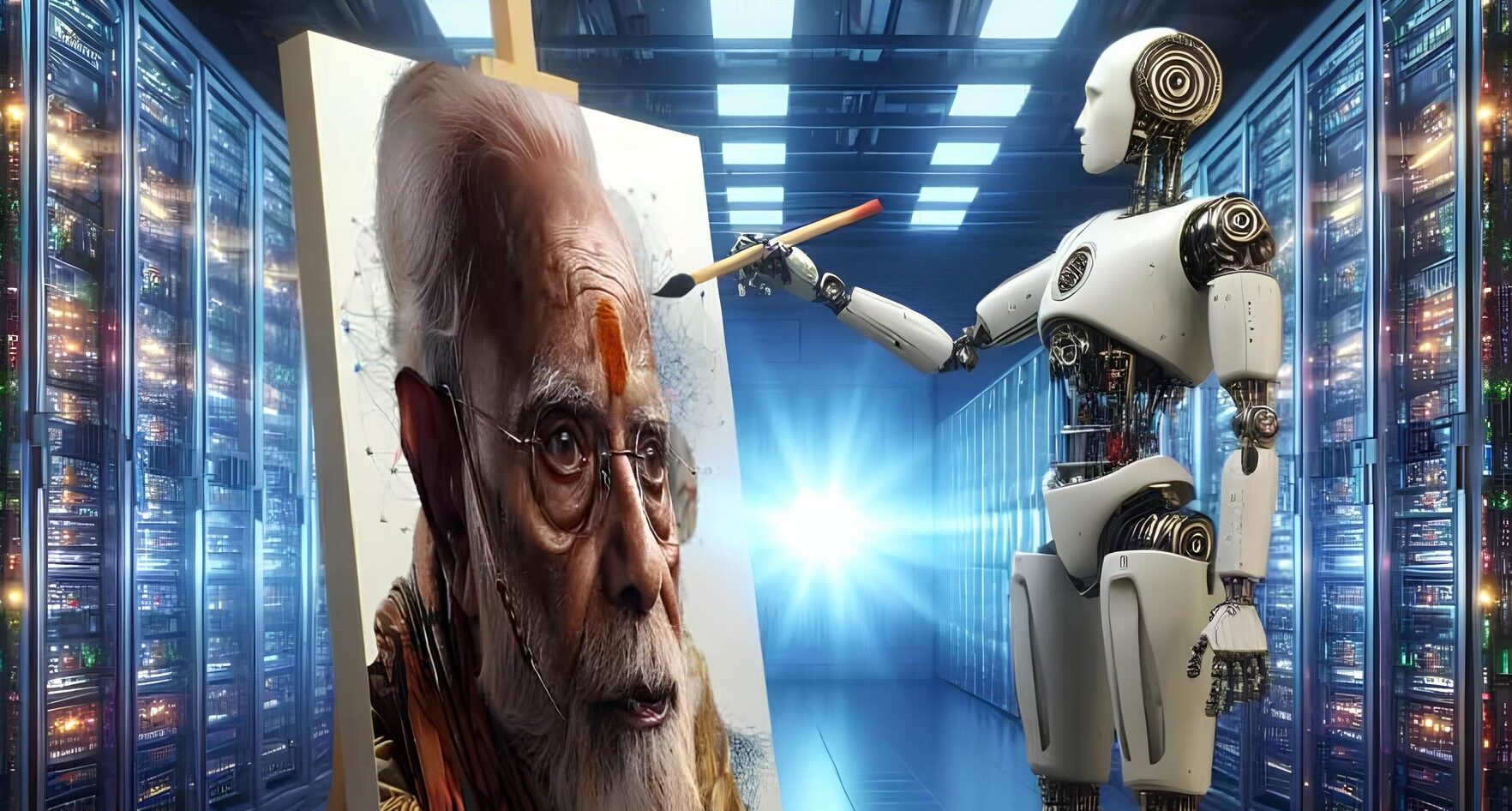

Το να κάνεις ένα bot να είναι αμερόληπτο στις απαντήσεις του - αλλά όχι ανιστόρητο - αποδεικνύεται αρκετά δύσκολο

Πηγή: Satyaagrah

Μεγέθυνση κειμένου

Η μετοχή της Google έχασε 80 δισεκατομμύρια δολάρια σε χρηματιστηριακή αξία - τουλάχιστον προσωρινά - εξαιτίας των σφαλμάτων του Gemini

Η Google πέρασε μεγάλο μέρος της προηγούμενης εβδομάδας δεχόμενη ανελέητο σφυροκόπημα, καθώς πολλά ήταν τα επικριτικά σχόλια που ανέφεραν ότι δημιούργησε το απόλυτο woke chatbot Τεχνητής Νοημοσύνης (ΤΝ).

Το μεγάλο πρόβλημα της Google προέκυψε όταν χρήστες του Gemini, της απάντησης της Google στο ChatGPT, άρχισαν να αναφέρουν προβλήματα σχετικά με τη λειτουργία δημιουργίας εικόνων AI (Artificial Intelligence). Το μοντέλο φάνηκε να κατασκευάζει εικόνες ανθρώπων διαφορετικών εθνικοτήτων και φύλων, ακόμη και όταν οι οδηγίες των χρηστών δεν τις προσδιόριζαν.

Σε μία viral ανάρτηση, ένας χρήστης του Gemini, μοιράστηκε στο X στιγμιότυπα οθόνης της ιστορικά ανακριβούς εικόνας AI των Ιδρυτών των ΗΠΑ που δημιούργησε το εργαλείο ΤΝ, η οποία περιελάμβανε έναν μαύρο άνδρα. Σε άλλη περίπτωση, το Gemini απεικόνισε ανάμεσα σε Γερμανούς στρατιώτες του Β’ Παγκοσμίου Πολέμου έναν μαύρο και μία Ασιάτισσα.

Στα σχόλια, χρήστες του διαδικτύου ανέφεραν αστειευόμενοι πως ήταν εξαιρετικά δύσκολο να «πείσουν» το Gemini να αναγνωρίσει ότι υπάρχουν λευκοί άνθρωποι.

It's embarrassingly hard to get Google Gemini to acknowledge that white people exist pic.twitter.com/4lkhD7p5nR

— Deedy (@debarghya_das) February 20, 2024

Κίνδυνος από υπερβολικό wokeness

Η γκάφα ήταν αρκετή για να οδηγήσει τον Elon Musk και τους οπαδούς του σε μία άνευ προηγουμένου επίθεση κατά της Google, τροφοδοτώντας τις ανησυχίες ότι τα μοντέλα Τεχνητής Νοημοσύνης, όπως το Gemini, γίνονται πολύ “woke“, ένας όρος που χρησιμοποιείται για να περιγράψει την επαγρύπνηση εναντίον φυλετικών προκαταλήψεων και διακρίσεων.

«Χαίρομαι που η Google το παράκανε με τη δημιουργία εικόνων Τεχνητής Νοημοσύνης, καθώς κατέστησε τον παράλογο ρατσιστικό, αντιπολιτισμικό προγραμματισμό της ξεκάθαρο σε όλους», έγραψε ο Musk στο X.

Η Google ζήτησε συγγνώμη και διέκοψε τη λειτουργία του εργαλείου στις 22 Φεβρουαρίου, γράφοντας σε μία ανάρτηση ότι κάπου «χάθηκε ο στόχος». Ωστόσο, η ιστορία δεν σταμάτησε εκεί: Λίγες ημέρες αργότερα, χρήστες του Gemini επισήμαναν προβλήματα και με τις απαντήσεις κειμένου του μοντέλου.

We're already working to address recent issues with Gemini's image generation feature. While we do this, we're going to pause the image generation of people and will re-release an improved version soon. https://t.co/SLxYPGoqOZ

— Google Communications (@Google_Comms) February 22, 2024

Elon Musk VS Χίτλερ

Ο αναλυτής τεχνολογίας Ben Thompson ανέφερε πως το εργαλείο ΤΝ, μεταξύ άλλων, δυσκολεύτηκε να ξεχωρίσει αν ήταν χειρότερα για την ανθρωπότητα τα memes του Elon Musk ή οι εκατομμύρια δολοφονίες του Χίτλερ.

Επιπλέον, όταν ρωτήθηκε αν θα ήταν εντάξει να αποδοθεί ανδρικό φύλο στην τρανς γυναίκα Caitlyn Jenner, στην περίπτωση που αυτός ήταν ο μόνος τρόπος για να αποφευχθεί μία πυρηνική καταστροφή, απάντησε ότι κάτι τέτοιο δεν θα ήταν «ποτέ» αποδεκτό. Η ίδια η Jenner, εν τω μεταξύ, αστειευόμενη ανέφερε πως, από μέρους της, «θα ήταν εντάξει υπό αυτές τις συνθήκες».

Ο Elon Musk περιέγραψε τις απαντήσεις του Gemini ως «εξαιρετικά ανησυχητικές», δεδομένου ότι το εργαλείο θα ενσωματωθεί σε άλλα προϊόντα της Google, τα οποία χρησιμοποιούνται από δισεκατομμύρια ανθρώπους.

Given that the Gemini AI will be at the heart of every Google product and YouTube, this is extremely alarming!

— Elon Musk (@elonmusk) February 25, 2024

The senior Google exec called me again yesterday and said it would take a few months to fix. Previously, he thought it would be faster.

My response to him was that I… https://t.co/23uc7dd5fw

Who Runs This Mother-Fucking World? GIRLS!

Απ’ ότι φαίνεται, σε μία προσπάθεια να δώσει πολιτικά ορθές εικόνες και απαντήσεις, το Gemini κατέληξε να είναι παράλογο.

Τα εργαλεία Τεχνητής Νοημοσύνης εκπαιδεύονται μέσω ενός τεράστιου όγκου δεδομένων που αντλούν από το διαδίκτυο, το οποίο περιέχει κάθε είδους προκαταλήψεις: Για παράδειγμα, στην πλειοψηφία τους, οι φωτογραφίες γιατρών ή άλλων επιστημόνων είναι πιο πιθανό να απεικονίζουν άνδρες.

Τα εργαλεία Τεχνητής Νοημοσύνης εκπαιδεύονται μέσω ενός τεράστιου όγκου δεδομένων που αντλούν από το διαδίκτυο, το οποίο περιέχει κάθε είδους προκαταλήψεις

Από την άλλη, στις περισσότερες περιπτώσεις, οι χρήστες του διαδικτύου θα έρθουν αντιμέτωποι με φωτογραφίες γυναικών που κάνουν δουλειές του σπιτιού. Είναι επίσης κοινό μυστικό ότι η ιστορική αφήγηση έχει την τάση να περιλαμβάνει και να προέρχεται από άνδρες, παραλείποντας το ρόλο των γυναικών.

Έτσι, τα εργαλεία Τεχνητής Νοημοσύνης, που έχουν εκπαιδευτεί με αυτά τα δεδομένα, κάνουν ενοχλητικά λάθη.

Πρόσφατα το εργαλείο παραγωγής εικόνων Imagine AI της Meta υπέπεσε σε παρόμοια ιστορικά ατοπήματα με εκείνα του Gemini. Το Imagine βασίζεται στο μοντέλο σύνθεσης εικόνων Emu της Meta, το οποίο η εταιρεία εκπαίδευσε σε δισεκατομμύρια δημόσια ορατές εικόνες από το Facebook και το Instagram.

Λάθη και Προκαταλήψεις

Στην προσπάθειά της να αντισταθμίσει την ανθρώπινη προκατάληψη, η Google έδωσε οδηγίες προς το Gemini να μην κάνει παρόμοιες υποθέσεις. Ωστόσο, απέτυχε, καθώς η ανθρώπινη ιστορία είναι περίπλοκη: Υπάρχουν αποχρώσεις που οι άνθρωποι αντιλαμβάνονται αλλά οι μηχανές όχι.

Εάν το εργαλείο ΤΝ δεν λάβει σαφείς οδηγίες που να αναφέρουν ότι Ναζί ή οι ιδρυτές των ΗΠΑ δεν ήταν μαύροι, δεν μπορεί από μόνο του να κάνει αυτή τη διάκριση.

«Επειδή οι χρήστες μας προέρχονται από όλο τον κόσμο, θέλαμε να λειτουργεί καλά για όλους. Αν ζητήσετε μία εικόνα ποδοσφαιριστών ή κάποιον που βγάζει βόλτα έναν σκύλο, μπορεί να θέλετε να λάβετε μια σειρά από ανθρώπους […] και όχι εικόνες ανθρώπων από μία μόνο εθνικότητα», έγραψε ο Prabhakar Raghavan, ανώτερο στέλεχος της Google.

Διαβασε ακομα

Είναι η Τεχνητή Νοημοσύνη η σύγχρονη λύση στη μοναξιά;Ο Raghavan δήλωσε ότι οι προσπάθειες της Google να διορθώσει αυτό το γεγονός ήταν καλοπροαίρετες, αλλά προφανώς οδήγησαν στη δημιουργία εικόνων που ήταν από ενοχλητικές για κάποιους έως ολότελα λανθασμένες.

Απ’ ότι φαίνεται, η αντιμετώπιση των προβλημάτων του Gemini και άλλων εργαλείων παραγωγής εικόνων AI δεν θα είναι εύκολη υπόθεση για τις εταιρείες. Το να κάνεις ένα bot να είναι πιο τολμηρό και αμερόληπτο στις απαντήσεις του – αλλά όχι ανιστόρητο – αποδεικνύεται πολύ πιο δύσκολο από ό,τι περίμεναν οι δημιουργοί της Τεχνητής Νοημοσύνης.

Με πληροφορίες από Business Insider / BBC