Οι ομάδες ασφάλειας λένε ότι βρίσκουν όλο και περισσότερες συζητήσεις για τη δημιουργία εικόνων με βάση υλικό σεξουαλικής κακοποίησης παιδιών στο παρελθόν

«Το σώμα μου δεν θα είναι ποτέ ξανά δικό μου»: Η AI στην υπηρεσία παιδεραστών για δημιουργία πορνογραφικού περιεχομένου

Οι ομάδες ασφάλειας λένε ότι βρίσκουν όλο και περισσότερες συζητήσεις για τη δημιουργία εικόνων με βάση υλικό σεξουαλικής κακοποίησης παιδιών στο παρελθόν

Οι ομάδες ασφάλειας λένε ότι βρίσκουν όλο και περισσότερες συζητήσεις για τη δημιουργία εικόνων με βάση υλικό σεξουαλικής κακοποίησης παιδιών στο παρελθόν

Οι ομάδες ασφάλειας λένε ότι βρίσκουν όλο και περισσότερες συζητήσεις για τη δημιουργία εικόνων με βάση υλικό σεξουαλικής κακοποίησης παιδιών στο παρελθόν

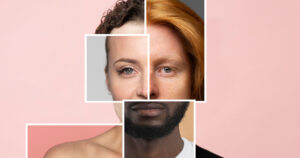

Επιτήδειοι που δραστηριοποιούνται στο dark web χρησιμοποιούν όλο και περισσότερο την Τεχνητή Νοημοσύνη για να δημιουργήσουν σεξουαλικά αποκαλυπτικές εικόνες παιδιών, εστιάζοντας ιδιαίτερα σε διάσημα θύματα, προειδοποιούν οι ειδικοί σε θέματα ασφάλειας των παιδιών.

Ομάδες για την ασφάλεια των παιδιών που παρακολουθούν τη δραστηριότητα των αρπακτικών που συνομιλούν σε φόρουμ του σκοτεινού ιστού λένε ότι βρίσκουν όλο και περισσότερο συζητήσεις για τη δημιουργία νέων εικόνων που βασίζονται σε παλαιότερο υλικό σεξουαλικής κακοποίησης παιδιών (CSAM). Πολλά από αυτά τα αρπακτικά που χρησιμοποιούν Τεχνητή Νοημοσύνη έχουν εμμονή με τα παιδιά-θύματα που αναφέρονται ως «αστέρια» στις κοινότητες των αρπακτικών για τη δημοτικότητα των εικόνων τους.

«Οι κοινότητες των ανθρώπων που εμπορεύονται αυτό το υλικό ξεμυαλίζονται με συγκεκριμένα παιδιά», δήλωσε η Σάρα Γκάρντνερ, διευθύνουσα σύμβουλος της Heat Initiative, μιας μη κερδοσκοπικής οργάνωσης του Λος Άντζελες που επικεντρώνεται στην προστασία των παιδιών. «Θέλουν περισσότερο περιεχόμενο από αυτά τα παιδιά, κάτι που η AI τους έχει πλέον επιτρέψει να κάνουν».

Αυτοί οι επιζώντες της κακοποίησης μπορεί να είναι πλέον ενήλικες, αλλά η Τεχνητή Νοημοσύνη έχει επιδεινώσει την προοπτική ότι περισσότεροι άνθρωποι μπορεί να βλέπουν σεξουαλικό περιεχόμενο που τους απεικονίζει ως παιδιά, σύμφωνα με τους εμπειρογνώμονες και τους επιζώντες της κακοποίησης που ερωτήθηκαν. Φοβούνται ότι οι εικόνες τους που κυκλοφορούν στο διαδίκτυο ή στις κοινότητές τους θα μπορούσαν να απειλήσουν τις ζωές και τις καριέρες που έχτισαν μετά το τέλος της κακοποίησής τους.

Η Μέγκαν, επιζήσασα από την CSAM, της οποίας το επώνυμο αποκρύπτεται λόγω προηγούμενων βίαιων απειλών, λέει ότι το ενδεχόμενο να χρησιμοποιηθεί η Τεχνητή Νοημοσύνη για τη διαχείριση των εικόνων της έχει γίνει μια όλο και πιο αγχωτική προοπτική τους τελευταίους 12 μήνες, αν και η δική της κακοποίηση συνέβη πριν από μια δεκαετία.

«Η Τεχνητή Νοημοσύνη δίνει στους δράστες την ευκαιρία να δημιουργήσουν ακόμη περισσότερες καταστάσεις κακοποίησής μου για να τροφοδοτήσουν τις δικές τους φαντασιώσεις και τις δικές τους εκδοχές», δήλωσε. «Ο τρόπος με τον οποίο οι φωτογραφίες μου θα μπορούσαν να χρησιμοποιηθούν με την Τεχνητή Νοημοσύνη θα μπορούσε να δώσει την ψευδή εντύπωση ότι δεν ήταν επιβλαβής ή ότι απολάμβανα την κακοποίηση».

Δεδομένου ότι οι dark web browsers επιτρέπουν στους χρήστες να είναι ανώνυμοι ή μη ανιχνεύσιμοι, οι ομάδες για την ασφάλεια των παιδιών έχουν ελάχιστα μέσα για να ζητήσουν την αφαίρεση αυτών των εικόνων ή να καταγγείλουν τους χρήστες στις διωκτικές Αρχές.

Οι συνήγοροι έχουν ζητήσει τη θέσπιση νομοθεσίας που να υπερβαίνει την ποινικοποίηση για την πρόληψη της παραγωγής CSAM, με Τεχνητή Νοημοσύνη και με άλλους τρόπους. Ωστόσο, είναι απαισιόδοξοι, πιστεύοντας ότι δεν μπορούν να γίνουν πολλά για να επιβληθούν απαγορεύσεις στη δημιουργία νέων σεξουαλικοποιημένων εικόνων παιδιών, τώρα που η Τεχνητή Νοημοσύνη που το επιτρέπει έχει γίνει ανοικτού κώδικα και ιδιωτική. Οι κρυπτογραφημένες υπηρεσίες ανταλλαγής μηνυμάτων, που πλέον είναι συχνά προεπιλεγμένες ρυθμίσεις, επιτρέπουν στα αρπακτικά να επικοινωνούν απαρατήρητα, λένε οι υπέρμαχοι.

Δημιουργία νέων CSAM και επαναφορά παλαιών CSAM με Τεχνητή Νοημοσύνη

Ο Guardian είδε αρκετά αποσπάσματα από αυτές τις συνομιλίες σε δωμάτια συνομιλιών του σκοτεινού διαδικτύου, με τα ονόματα των θυμάτων να έχουν αποσυρθεί για λόγους προστασίας. Οι συζητήσεις έχουν φιλικό τόνο και τα μέλη του φόρουμ ενθαρρύνονται να δημιουργήσουν νέες εικόνες με AI για να τις μοιραστούν στις ομάδες. Πολλοί δήλωσαν ενθουσιασμένοι με την προοπτική νέου υλικού που δημιουργήθηκε με AI, άλλοι δεν ενδιαφέρθηκαν επειδή οι εικόνες δεν απεικονίζουν πραγματική κακοποίηση.

Ένα μήνυμα από τον Νοέμβριο του 2023 αναφέρει: «Θα μπορούσατε να βάλετε την Τεχνητή Νοημοσύνη να αναδημιουργήσει τις όμορφες εικόνες των πρώην αστέρων του CP [παιδικό πορνό] [όνομα θύματος με αναδιατύπωση] και [όνομα θύματος με αναδιατύπωση] και να τις βάλει σε κάποιες σκηνές – όπως [όνομα θύματος με αναδιατύπωση] με παραδοσιακή στολή καθολικής μαθήτριας στο Δημοτικό Σχολείο και [όνομα θύματος με αναδιατύπωση] με στολή μαζορέτας στο Γυμνάσιο;».

Σε μια άλλη συνομιλία στο chat room, οι επιτήδειοι συζήτησαν επίσης τη χρήση της Τεχνητής Νοημοσύνης για την ψηφιακή ανακατασκευή δημοφιλούς υλικού παιδικής εκμετάλλευσης δεκαετιών χαμηλής ποιότητας.

«Ουάου, είσαι φοβερός», έγραψε ένα αρπακτικό σε ένα άλλο τον Ιανουάριο. «Εκτιμώ την προσπάθειά σου να συνεχίσεις να αναβαθμίζεις τα κλασικά βίντεο».

Ενώ οι επιτήδειοι έχουν χρησιμοποιήσει στο παρελθόν λογισμικό επεξεργασίας φωτογραφιών, οι νέες εξελίξεις στα μοντέλα Τεχνητής Νοημοσύνης παρουσιάζουν εύκολα προσβάσιμες ευκαιρίες για τη δημιουργία πιο ρεαλιστικών εικόνων κακοποίησης παιδιών.

Μεγάλο μέρος αυτής της δραστηριότητας επικεντρώνεται στα λεγόμενα «αστέρια».

«Με τον ίδιο τρόπο που υπάρχουν διασημότητες στο Χόλιγουντ, σε αυτές τις διαδικτυακές κοινότητες του σκοτεινού ιστού, υπάρχει μια κατάταξη που μοιάζει με την κατάταξη των διασημοτήτων σε κάποια από τα αγαπημένα θύματα», δήλωσε ο Jacques Marcoux, διευθυντής έρευνας και ανάλυσης στο Καναδικό Κέντρο Προστασίας Παιδιών. «Αυτές οι ομάδες των δραστών τους γνωρίζουν όλους και τους καταγράφουν».

«Οι δράστες τελικά εξαντλούν όλο το υλικό ενός συγκεκριμένου θύματος», δήλωσε ο Marcoux. «Έτσι, μπορούν να πάρουν μια εικόνα ενός θύματος που τους αρέσει και μπορούν να κάνουν το θύμα να κάνει διαφορετικές πόζες ή να κάνει διαφορετικά πράγματα. Μπορούν να το ωθήσουν με ένα μοντέλο Τεχνητής Νοημοσύνης να κάνει διαφορετικές πόζες σε ένα κρεβάτι ή να βρίσκεται σε διαφορετικά στάδια απογύμνωσης».

Τα δεδομένα επιβεβαιώνουν το φαινόμενο της ενασχόλησης των αρπακτικών με τα «αστέρια». Σε μια αξιολόγηση του 2020 προς το Εθνικό Κέντρο για τα Εξαφανισμένα και Εκμεταλλευόμενα Παιδιά, η Meta ανέφερε ότι μόλις έξι βίντεο αντιπροσώπευαν το ήμισυ του συνόλου του υλικού σεξουαλικής κακοποίησης παιδιών που μοιράζεται και αναδιανέμεται στο Facebook και το Instagram. Περίπου το 90% του υλικού κακοποίησης που εντόπισε η Meta σε μια περίοδο δύο μηνών ήταν το ίδιο με το περιεχόμενο που είχε αναφερθεί προηγουμένως.

Οι πραγματικές διασημότητες του Χόλιγουντ είναι επίσης πιθανοί στόχοι θυματοποίησης με CSAM που δημιουργείται από Τεχνητή Νοημοσύνη. Ο Guardian εξέτασε threads chatroom στο dark web που συζητούσαν τις επιθυμίες των αρπακτικών που είναι ικανοί στην Τεχνητή Νοημοσύνη να δημιουργήσουν εικόνες παιδικής κακοποίησης διασημοτήτων, συμπεριλαμβανομένων των εφηβικών ειδώλων της δεκαετίας του 1990 που τώρα είναι ενήλικες.

Πώς διαδίδεται το υλικό σεξουαλικής κακοποίησης παιδιών που φτιάχνεται από την Τεχνητή Νοημοσύνη

Η χρήση της Τεχνητής Νοημοσύνης από τους επιτήδειους επικράτησε στα τέλη του 2022, δήλωσαν οι ειδικοί σε θέματα ασφάλειας των παιδιών. Την ίδια χρονιά που το OpenAI έκανε το ντεμπούτο του ChatGPT, η βάση δεδομένων LAION-5B, ένας κατάλογος ανοικτού κώδικα με περισσότερες από 5 δισεκατομμύρια εικόνες που μπορεί να χρησιμοποιήσει ο καθένας για να εκπαιδεύσει μοντέλα AI, ξεκίνησε από έναν ομώνυμο μη κερδοσκοπικό οργανισμό.

Μια έκθεση του Πανεπιστημίου του Στάνφορντ που κυκλοφόρησε τον Δεκέμβριο του 2023 αποκάλυψε ότι εκατοντάδες γνωστές εικόνες σεξουαλικής κακοποίησης παιδιών είχαν συμπεριληφθεί στο LAION-5B και τώρα χρησιμοποιούνται για την εκπαίδευση δημοφιλών μοντέλων δημιουργίας εικόνων Τεχνητής Νοημοσύνης για τη δημιουργία CSAM. Παρόλο που οι εικόνες ήταν ένα μικρό κλάσμα ολόκληρης της βάσης δεδομένων, ενέχουν τεράστιο κίνδυνο, δήλωσαν οι ειδικοί.

«Από τη στιγμή που αυτά τα πράγματα ήταν ανοικτού κώδικα, τότε ήταν που η παραγωγή της AI generative CSAM εξερράγη», δήλωσε ο Dan Sexton, επικεφαλής τεχνολογίας στο Ίδρυμα Internet Watch, μια μη κερδοσκοπική οργάνωση με έδρα το Ηνωμένο Βασίλειο που επικεντρώνεται στην πρόληψη της διαδικτυακής παιδικής κακοποίησης.

Η γνώση ότι χρησιμοποιούνται πραγματικές εικόνες κακοποίησης για την εκπαίδευση μοντέλων Τεχνητής Νοημοσύνης είχε ως αποτέλεσμα πρόσθετο τραύμα για ορισμένους επιζώντες.

«Μη συναινετικές εικόνες μου από όταν ήμουν 14 ετών μπορούν να αναβιώσουν για να δημιουργήσουν νέες εικόνες σεξουαλικής κακοποίησης παιδιών και βίντεο με θύματα σε όλο τον κόσμο», δήλωσε η Leah Juliett, 27 ετών, επιζήσασα υλικού σεξουαλικής κακοποίησης παιδιών και ακτιβίστρια. «Το να γνωρίζω ότι οι φωτογραφίες μου μπορούν ακόμα να χρησιμοποιηθούν ως όπλο χωρίς τη συγκατάθεσή μου για να βλάψουν άλλα μικρά παιδιά, είναι ένας πόνος και ένα αίσθημα αδυναμίας και αδικίας».

«Το σώμα μου δεν θα είναι ποτέ ξανά δικό μου και αυτό είναι κάτι που πολλοί επιζώντες πρέπει να αντιμετωπίσουν», πρόσθεσε.

Οι ειδικοί λένε ότι έχουν παρατηρήσει μια στροφή προς τα αρπακτικά που χρησιμοποιούν κρυπτογραφημένες ιδιωτικές υπηρεσίες ανταλλαγής μηνυμάτων όπως το WhatsApp, το Signal και το Telegram για τη διάδοση και την πρόσβαση σε CSAM. Ωστόσο, μεγάλο μέρος του CSAM εξακολουθεί να μοιράζεται εκτός των καθιερωμένων καναλιών στο σκοτεινό διαδίκτυο. Σε μια έκθεση του Οκτωβρίου 2023, το Ίδρυμα Internet Watch Foundation (IWF) αναφέρει ότι βρήκε περισσότερες από 20.000 σεξουαλικές εικόνες παιδιών που δημιουργήθηκαν με Τεχνητή Νοημοσύνη και δημοσιεύθηκαν σε ένα μόνο φόρουμ στο dark web σε διάστημα ενός μηνός τον Σεπτέμβριο.

«Οι εικόνες δείχνουν τον βιασμό μωρών και νηπίων, διάσημα παιδιά προεφηβικής ηλικίας που κακοποιούνται σεξουαλικά, BDSM, περιεχόμενο με tweens και εφήβους και πολλά άλλα», αναφέρεται στην έκθεση.

Τον τελευταίο χρόνο, οι AI generators εικόνων έχουν βελτιωθεί σε όλους τους τομείς και η παραγωγή τους έχει γίνει όλο και πιο ρεαλιστική. Οι ειδικοί σε θέματα παιδικής ασφάλειας δήλωσαν ότι οι εικόνες που δημιουργούνται με Τεχνητή Νοημοσύνη είναι συχνά δυσδιάκριτες από φωτογραφίες της πραγματικής ζωής.

«Βλέπουμε να γίνονται συζητήσεις όπου [οι παραβάτες] συζητούν πώς να διορθώσουν προβλήματα, όπως ενδείξεις ότι η εικόνα είναι ψεύτικη, όπως επιπλέον δάχτυλα. Βρίσκουν λύσεις. Ο ρεαλισμός γίνεται όλο και καλύτερος», δήλωσε ο Sexton. «Υπάρχει ζήτηση για τη δημιουργία περισσότερων εικόνων υπαρχόντων θυμάτων με τη χρήση λεπτομερών μοντέλων».

Τι επιπτώσεις θα έχει το CSAM που δημιουργείται από την Τεχνητή Νοημοσύνη;

Οι εμπειρογνώμονες λένε ότι ο αντίκτυπος της CSAM που δημιουργείται από την Τεχνητή Νοημοσύνη μόλις τώρα αρχίζει να μπαίνει στο επίκεντρο. Σε ορισμένες περιπτώσεις, η προβολή CSAM στο διαδίκτυο μπορεί να προκαλέσει την κλιμάκωση της συμπεριφοράς ενός αρπακτικού σε διάπραξη αδικημάτων επαφής με παιδιά, και μένει να δούμε πώς η Τεχνητή Νοημοσύνη παίζει ρόλο σε αυτή τη δυναμική.

«Υπάρχουν παραδείγματα ανδρών με τους οποίους έχω δουλέψει, όπου η διαδικτυακή τους συμπεριφορά ενίσχυσε το σεξουαλικό τους ενδιαφέρον για τα παιδιά και οδήγησε σε μεγαλύτερη ενασχόληση με αυτού του είδους τη συμπεριφορά», δήλωσε ο Tom Squire, επικεφαλής της κλινικής δέσμευσης στο Ίδρυμα Lucy Faithfull στο Ηνωμένο Βασίλειο, ένα μη κερδοσκοπικό ίδρυμα που επικεντρώνεται στην πρόληψη της σεξουαλικής κακοποίησης παιδιών. Ο οργανισμός λειτουργεί μια ανώνυμη γραμμή βοήθειας για οποιονδήποτε ανησυχεί για τη σεξουαλική κακοποίηση παιδιών, συμπεριλαμβανομένων των δικών του σκέψεων ή συμπεριφορών.

«Εντάχθηκαν σε μια διαδικτυακή ομάδα όπου υπήρχε ένα νόμισμα για την ανταλλαγή εικόνων, και ήθελαν να συμβάλουν σε αυτό, και στη συνέχεια, απευθείας από εκεί, προχώρησαν στη σεξουαλική κακοποίηση παιδιών, και ίσως να έπαιρναν εικόνες αυτής της κακοποίησης και να τις μοιράζονταν στο διαδίκτυο», δήλωσε ο Squire.

Ορισμένα αρπακτικά πιστεύουν λανθασμένα ότι η προβολή CSAM που δημιουργείται από Τεχνητή Νοημοσύνη μπορεί να είναι πιο ηθική από το υλικό της «πραγματικής ζωής», δήλωσαν οι ειδικοί.

«Μία από τις ανησυχίες μας είναι η ικανότητά τους να δικαιολογούν τη συμπεριφορά τους επειδή πρόκειται κατά κάποιο τρόπο για εικόνες ενός εγκλήματος χωρίς θύματα που δεν συνεπάγεται βλάβη στον πραγματικό κόσμο», δήλωσε ο Squire. «Μερικοί από τους ανθρώπους που μας τηλεφωνούν προβάλλουν ένα επιχείρημα για να ελαχιστοποιήσουν τη σοβαρότητα αυτού που κάνουν».

Τι μπορεί να γίνει για να περιοριστούν οι σεξουαλικές εικόνες παιδιών που δημιουργούνται από την Τεχνητή Νοημοσύνη;

Σε πολλές χώρες, συμπεριλαμβανομένων των ΗΠΑ και του Ηνωμένου Βασιλείου, οι νόμοι δεκαετιών ήδη ποινικοποιούν κάθε CSAM που δημιουργείται με τη χρήση Τεχνητής Νοημοσύνης μέσω απαγορεύσεων για κάθε άσεμνη ή χυδαία οπτική απεικόνιση παιδιών. Οι πορνογραφικές απεικονίσεις της Taylor Swift που δημιουργήθηκαν από AI και κυκλοφόρησαν στις αρχές του τρέχοντος έτους προκάλεσαν την εισαγωγή νομοθεσίας στις ΗΠΑ που θα ρυθμίζει τέτοιου είδους deepfakes.

Τον Απρίλιο, ένας 51χρονος Αμερικανός συνελήφθη στη Φλόριντα με την κατηγορία ότι δημιούργησε CSAM χρησιμοποιώντας Τεχνητή Νοημοσύνη με το πρόσωπο ενός παιδιού που είχε φωτογραφίσει στη γειτονιά του. Στις 20 Μαΐου, το Υπουργείο Δικαιοσύνης των ΗΠΑ ανακοίνωσε τη σύλληψη ενός 42χρονου άνδρα στο Ουισκόνσιν με ποινικές κατηγορίες που σχετίζονται με την υποτιθέμενη παραγωγή, διανομή και κατοχή περισσότερων από 10.000 εικόνων που δημιουργήθηκαν με Τεχνητή Νοημοσύνη και απεικόνιζαν ανηλίκους που εμπλέκονται σε σεξουαλικά ξεκάθαρη συμπεριφορά.

«Χρειαζόμαστε νομοθετική μεταρρύθμιση για να διασφαλίσουμε ότι η κακοποίηση δεν έχει χώρο για να φουντώσει», δήλωσε η Juliett. «Αλλά χρειαζόμαστε επίσης πολιτισμική μεταρρύθμιση για να σταματήσουμε την κακοποίηση εξαρχής».

Οι εμπειρογνώμονες σε θέματα ασφάλειας των παιδιών και τεχνολογίας που ερωτήθηκαν ήταν απαισιόδοξοι για το κατά πόσον είναι δυνατόν να αποτραπεί η παραγωγή και η διανομή των CSAM που δημιουργούνται με Τεχνητή Νοημοσύνη. Τονίζουν ότι μεγάλο μέρος της παραγωγής περνά απαρατήρητο από τις Αρχές.

«Από τη στιγμή που έγινε ανοιχτός κώδικας, ήταν προβληματικό», δήλωσε ο Michael Tunks, επικεφαλής πολιτικής και δημόσιων υποθέσεων στο Ίδρυμα Internet Watch. «Οποιοσδήποτε μπορεί να χρησιμοποιήσει εργαλεία για να δημιουργήσει οποιαδήποτε εικόνα Τεχνητής Νοημοσύνης».

Το λογισμικό Τεχνητής Νοημοσύνης μπορεί να μεταφορτωθεί, πράγμα που σημαίνει ότι αυτές οι καταχρηστικές και παράνομες δραστηριότητες μπορούν να ληφθούν εκτός σύνδεσης.

«Αυτό σημαίνει ότι οι παραβάτες μπορούν να το κάνουν στην ιδιωτική ζωή του σπιτιού τους, εντός των τειχών του δικού τους δικτύου, επομένως δεν είναι επιρρεπείς στο να συλληφθούν να το κάνουν αυτό», δήλωσε ο Marcoux.

Με πληροφορίες από Guardian

Ακολουθήστε το pride.gr στο Google News και ενημερωθείτε πρώτοι